Vor- und Nachteile der gemeinsamen Nutzung von GPUs

Das Mooresche Gesetz hat seit fast einem halben Jahrhundert seine Gültigkeit behalten. In Prozessorchips werden immer mehr Transistoren verbaut, und die Technologien werden täglich weiterentwickelt. So wie sich die Technologie weiterentwickelt, so entwickelt sich auch unsere Herangehensweise an die Datenverarbeitung. Das Aufkommen bestimmter Computeraufgaben hat die Hardwareentwicklung erheblich beeinflusst. So sind beispielsweise Geräte, die ursprünglich für die Grafikverarbeitung entwickelt wurden, heute wichtige und erschwingliche Werkzeuge für moderne neuronale Netze.

Auch die Verwaltung von Computerressourcen hat sich verändert. Massendienste verwenden heute nur noch selten Großrechner, wie sie es in den 1970er und 80er Jahren taten. Stattdessen bevorzugen sie Cloud-Dienste oder bauen ihre eigene Infrastruktur auf. Diese Verschiebung hat die Kundenanforderungen verändert, wobei der Schwerpunkt auf einer schnellen, bedarfsgerechten Skalierung und einer maximalen Nutzung der zugewiesenen Computerressourcen liegt.

Virtualisierungs- und Containerisierungstechnologien sind als Lösungen entstanden. Anwendungen werden nun in Containern mit allen erforderlichen Bibliotheken verpackt, was die Bereitstellung und Skalierung vereinfacht. Die manuelle Verwaltung wurde jedoch unpraktisch, als die Zahl der Container in die Tausende stieg. Spezialisierte Orchestratoren wie Kubernetes sorgen nun für eine effektive Verwaltung und Skalierung. Diese Tools sind ein wesentlicher Bestandteil jeder modernen IT-Infrastruktur geworden.

Server-Virtualisierung

Gleichzeitig wurden Virtualisierungstechnologien entwickelt, die die Schaffung von isolierten Umgebungen innerhalb eines einzigen physischen Servers ermöglichen. Virtuelle Maschinen verhalten sich identisch zu normalen physischen Servern und ermöglichen die Verwendung von Standard-Verwaltungstools. Je nach Hypervisor ist oft eine spezielle API enthalten, die die Automatisierung von Routineabläufen erleichtert.

Diese Flexibilität geht jedoch mit einer geringeren Sicherheit einher. Angreifer konzentrieren sich nicht mehr auf einzelne virtuelle Maschinen, sondern nutzen die Schwachstellen von Hypervisoren aus. Wenn sie die Kontrolle über einen Hypervisor erlangen, können Angreifer nach Belieben auf alle zugehörigen virtuellen Maschinen zugreifen. Trotz laufender Sicherheitsverbesserungen bleiben moderne Hypervisoren attraktive Ziele.

Die herkömmliche Virtualisierung befasst sich mit zwei Hauptproblemen. Erstens: Sie gewährleistet die Isolierung der virtuellen Maschinen voneinander. Bare-Metal-Lösungen umgehen dieses Problem, da die Kunden ganze physische Server unter ihrer Kontrolle mieten. Bei virtuellen Maschinen erfolgt die Isolierung jedoch softwarebasiert auf der Hypervisor-Ebene. Ein Code-Fehler oder ein zufälliger Bug kann diese Isolierung beeinträchtigen, so dass die Gefahr besteht, dass Daten verloren gehen oder beschädigt werden.

Das zweite Problem betrifft die Ressourcenverwaltung. Es ist zwar möglich, die Ressourcenzuweisung für bestimmte virtuelle Maschinen zu garantieren, aber die Verwaltung zahlreicher Maschinen stellt ein Dilemma dar. Die Ressourcen können unzureichend genutzt werden, was zu einer geringeren Anzahl virtueller Maschinen pro physischem Server führt. Dieses Szenario ist für die Infrastruktur unrentabel und führt unweigerlich zu Preissteigerungen.

Alternativ dazu können Sie automatische Ressourcenverwaltungsmechanismen nutzen. Obwohl einer virtuellen Maschine bestimmte deklarierte Eigenschaften zugewiesen werden, wird in Wirklichkeit nur das erforderliche Minimum innerhalb dieser Grenzen bereitgestellt. Benötigt die Maschine mehr Prozessorzeit oder Arbeitsspeicher, versucht der Hypervisor, dies bereitzustellen, kann es aber nicht garantieren. Diese Situation ist vergleichbar mit der Überbuchung von Flugzeugen, bei der die Fluggesellschaften mehr Tickets verkaufen, als Plätze vorhanden sind.

Die Logik ist identisch. Wenn die Statistik zeigt, dass etwa 10 % der Passagiere nicht pünktlich zu ihrem Flug erscheinen, können die Fluggesellschaften mit minimalem Risiko 10 % mehr Tickets verkaufen. Wenn alle Passagiere kommen, werden einige nicht an Bord passen. Die Fluggesellschaft wird mit geringfügigen Konsequenzen in Form von Ausgleichszahlungen rechnen müssen, aber wahrscheinlich wird sie diese Praxis fortsetzen.

Viele Infrastrukturanbieter wenden eine ähnliche Strategie an. Einige sind transparent und geben an, dass sie die ständige Verfügbarkeit von Rechenressourcen nicht garantieren können, aber deutlich niedrigere Preise anbieten. Andere setzen ähnliche Mechanismen ein, ohne dies bekannt zu geben. Sie setzen darauf, dass nicht alle Kunden ihre Serverressourcen ständig zu 100 % ausnutzen werden, und selbst wenn es einige tun, werden sie in der Minderheit sein. In der Zwischenzeit erwirtschaften die ungenutzten Ressourcen Gewinn.

In diesem Zusammenhang haben Bare-Metal-Lösungen einen Vorteil. Sie garantieren, dass die zugewiesenen Ressourcen vollständig vom Kunden verwaltet und nicht mit anderen Nutzern des Infrastrukturanbieters geteilt werden. Dadurch werden Szenarien vermieden, in denen eine hohe Belastung durch den Benutzer eines benachbarten Servers die Leistung negativ beeinflusst.

GPU-Virtualisierung

Die klassische Virtualisierung steht unweigerlich vor der Herausforderung, physische Geräte zu emulieren. Um die Overhead-Kosten zu senken, wurden spezielle Technologien entwickelt, die es virtuellen Maschinen ermöglichen, direkt auf die physischen Geräte des Servers zuzugreifen. Dieser Ansatz funktioniert in vielen Fällen gut, aber bei der Anwendung auf Grafikprozessoren stößt er sofort an seine Grenzen. Wenn ein Server beispielsweise 8 Grafikprozessoren installiert hat, können nur 8 virtuelle Maschinen darauf zugreifen.

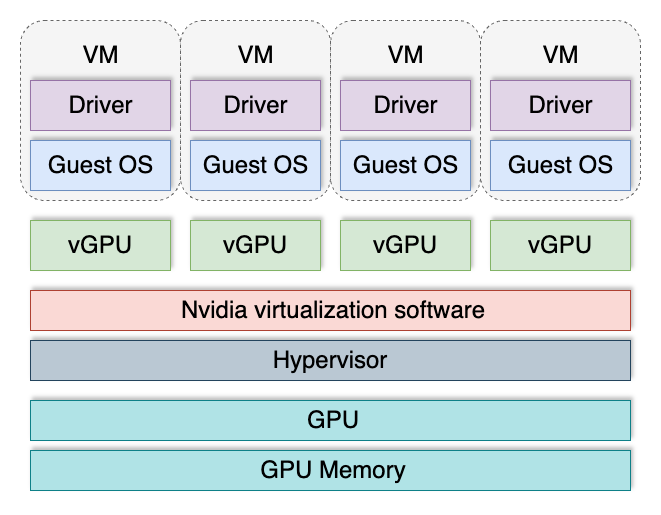

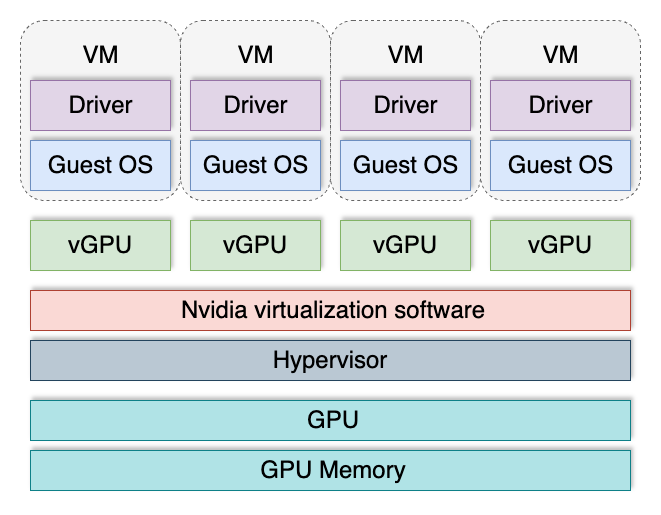

Um diese Einschränkung zu überwinden, wurde die vGPU-Technologie erfunden. Sie unterteilt eine GPU in mehrere logische GPUs, die dann virtuellen Maschinen zugewiesen werden können. Auf diese Weise kann jede virtuelle Maschine ihr "Stück vom Kuchen" bekommen, und ihre Gesamtzahl ist nicht mehr durch die Anzahl der im Server installierten Grafikkarten begrenzt.

Virtuelle GPUs werden am häufigsten beim Aufbau von VDI (Virtual Desktop Infrastructure) in Bereichen eingesetzt, in denen virtuelle Maschinen 3D-Beschleunigung benötigen. Ein virtueller Arbeitsplatz für einen Designer oder Planer beinhaltet beispielsweise typischerweise Grafikverarbeitung. Die meisten Anwendungen in diesen Bereichen führen Berechnungen sowohl auf dem zentralen Prozessor als auch auf dem Grafikprozessor durch. Dieser hybride Ansatz erhöht die Produktivität erheblich und gewährleistet eine optimale Nutzung der verfügbaren Rechenressourcen.

Diese Technologie hat jedoch mehrere Nachteile. Sie wird nicht von allen GPUs unterstützt und ist nur im Serverbereich verfügbar. Die Unterstützung hängt auch von der installierten Version des Betriebssystems und des GPU-Treibers ab. vGPU hat einen separaten Lizenzierungsmechanismus, der die Betriebskosten erheblich erhöht. Außerdem können die Softwarekomponenten potenziell als Angriffsvektoren dienen.

Vor kurzem wurden Informationen über acht Schwachstellen veröffentlicht, die alle Benutzer von Nvidia-GPUs betreffen. Sechs Schwachstellen wurden in GPU-Treibern und zwei in der vGPU-Software gefunden. Diese Probleme wurden schnell behoben, aber sie erinnern daran, dass die Isolationsmechanismen in solchen Systemen nicht fehlerfrei sind. Ständige Überwachung und die rechtzeitige Installation von Updates bleiben die wichtigsten Maßnahmen zur Gewährleistung der Sicherheit.

Beim Aufbau einer Infrastruktur zur Verarbeitung vertraulicher und sensibler Benutzerdaten wird jede Virtualisierung zu einem potenziellen Risikofaktor. In solchen Fällen kann ein Bare-Metal-Ansatz bessere Qualität und Sicherheit bieten.

Schlussfolgerung

Der Aufbau einer Computerinfrastruktur erfordert immer eine Risikobewertung. Zu den wichtigsten Fragen, die dabei zu berücksichtigen sind, gehören: Sind die Kundendaten sicher geschützt? Schaffen die gewählten Technologien zusätzliche Angriffsvektoren? Wie können potenzielle Schwachstellen isoliert und beseitigt werden? Die Beantwortung dieser Fragen hilft dabei, fundierte Entscheidungen zu treffen und sich vor künftigen Problemen zu schützen.

Bei LeaderGPU sind wir zu einer klaren Schlussfolgerung gelangt: Derzeit ist die Bare-Metal-Technologie überlegen, wenn es darum geht, die Sicherheit der Benutzerdaten zu gewährleisten und gleichzeitig eine hervorragende Grundlage für den Aufbau einer Bare-Metal-Cloud zu bieten. Mit diesem Ansatz können unsere Kunden ihre Flexibilität beibehalten, ohne die mit der GPU-Virtualisierung verbundenen zusätzlichen Risiken auf sich zu nehmen.

Siehe auch:

Aktualisiert: 04.01.2026

Veröffentlicht: 23.01.2025