Wie man die LangFlow-Anwendung überwacht

In unserem Artikel Low-Code-KI-App-Builder Langflow haben wir untersucht, wie man mit der visuellen Programmierumgebung dieses Low-Code-KI-App-Builders loslegen kann. Damit kann jeder, auch ohne Programmierkenntnisse, Anwendungen erstellen, die auf großen neuronalen Netzwerkmodellen basieren. Dabei kann es sich um KI-Chatbots oder Anwendungen zur Dokumentenverarbeitung handeln, die Inhalte analysieren und zusammenfassen können.

Langflow verwendet einen Bausteinansatz, bei dem die Benutzer vorgefertigte Komponenten miteinander verbinden, um ihre gewünschte Anwendung zu erstellen. Dabei treten jedoch häufig zwei zentrale Herausforderungen auf: die Fehlerbehebung bei unerwartetem Verhalten neuronaler Netze und das Kostenmanagement. Neuronale Netze erfordern beträchtliche Rechenressourcen, so dass es wichtig ist, die Infrastrukturkosten zu überwachen und vorherzusagen.

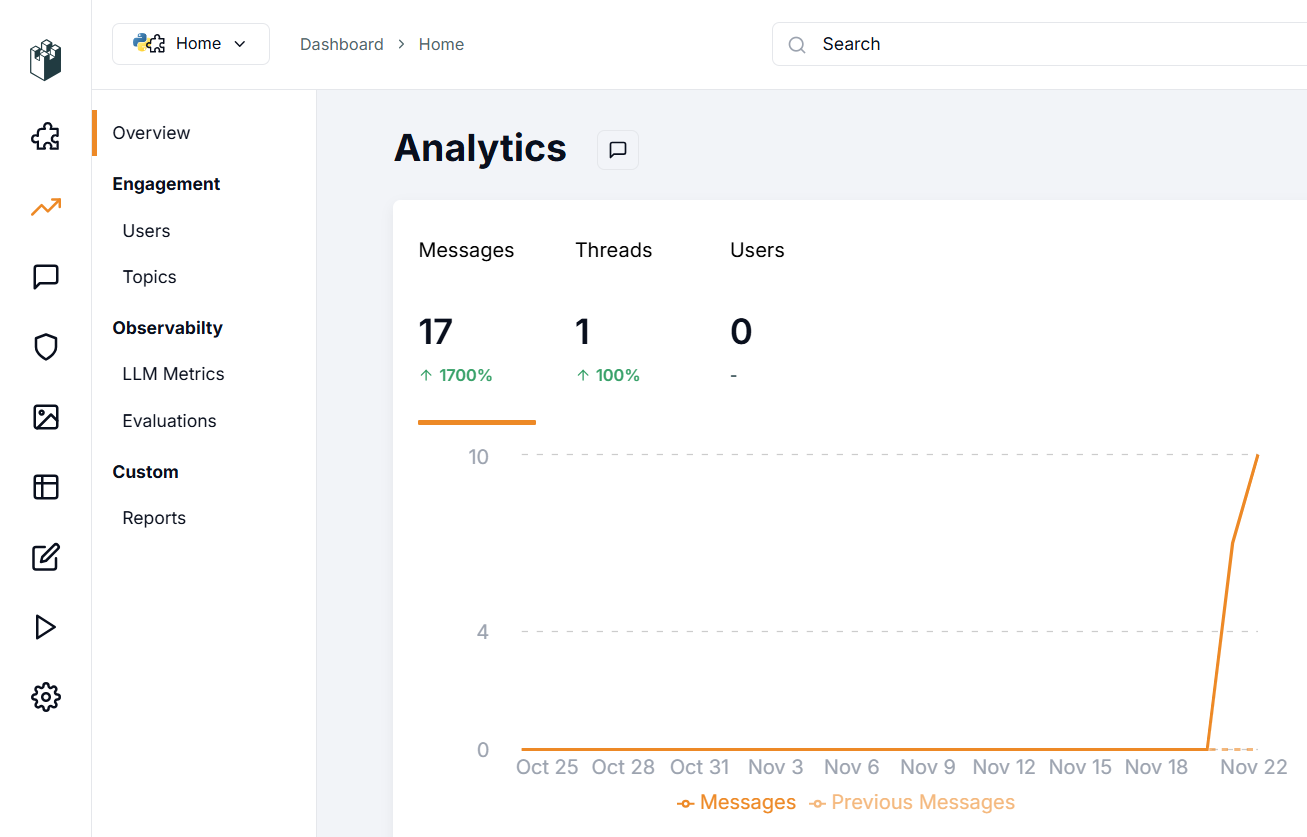

LangWatch geht beide Herausforderungen an. Dieses spezielle Tool hilft den Entwicklern von Langflow bei der Überwachung von Benutzeranfragen, der Verfolgung von Kosten und der Erkennung von Anomalien, z. B. wenn Anwendungen auf unbeabsichtigte Weise verwendet werden.

Dieses Tool wurde ursprünglich als Dienst entwickelt, kann aber auf jedem Server, auch lokal, eingesetzt werden. Es lässt sich mit den meisten LLM-Anbietern integrieren, egal ob Cloud-basiert oder vor Ort. Da LangWatch ein Open-Source-Tool ist, kann es an fast jedes Projekt angepasst werden, indem neue Funktionen hinzugefügt oder mit internen Systemen verbunden werden.

Mit LangWatch können Sie Warnungen einrichten, wenn bestimmte Metriken definierte Schwellenwerte überschreiten. So können Sie unerwartete Kostensteigerungen bei Anfragen oder ungewöhnliche Verzögerungen bei der Beantwortung schnell erkennen. Eine frühzeitige Erkennung hilft, ungeplante Ausgaben und potenzielle Service-Angriffe zu verhindern.

Für Forscher, die sich mit neuronalen Netzen beschäftigen, ermöglicht diese Anwendung sowohl die Überwachung als auch die Optimierung gängiger Benutzeranfragen. Außerdem bietet sie Werkzeuge zur Bewertung der Antwortqualität des Modells und zur Vornahme von Anpassungen, wenn dies erforderlich ist.

Schnellstart

System vorbereiten

Wie bei Langflow ist der einfachste Weg, die Anwendung in einem Docker-Container auszuführen. Bevor Sie LangWatch installieren, müssen Sie die Docker Engine auf Ihrem Server installieren. Aktualisieren Sie zunächst Ihren Paket-Cache und die Pakete auf ihre neuesten Versionen:

sudo apt update && sudo apt -y upgradeInstallieren Sie zusätzliche Pakete, die von Docker benötigt werden:

sudo apt -y install apt-transport-https ca-certificates curl software-properties-commonLaden Sie den GPG-Schlüssel herunter, um das offizielle Docker-Repository hinzuzufügen:

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpgFügen Sie das Repository zur APT hinzu, indem Sie den Schlüssel verwenden, den Sie zuvor heruntergeladen und installiert haben:

echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/nullAktualisieren Sie die Paketliste:

sudo apt updateUm sicherzustellen, dass Docker aus dem neu hinzugefügten Repository und nicht aus dem System-Repository installiert wird, können Sie den folgenden Befehl ausführen:

apt-cache policy docker-ceDocker-Engine installieren:

sudo apt install docker-ceÜberprüfen Sie, ob Docker erfolgreich installiert wurde und der entsprechende Daemon läuft und den Status active (running) hat:

sudo systemctl status docker● docker.service - Docker Application Container Engine

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset>

Active: active (running) since Mon 2024-11-18 08:26:35 UTC; 3h 27min ago

TriggeredBy: ● docker.socket

Docs: https://docs.docker.com

Main PID: 1842 (dockerd)

Tasks: 29

Memory: 1.8G

CPU: 3min 15.715s

CGroup: /system.slice/docker.service

Erstellen und Ausführen

Wenn die Docker-Engine installiert ist und läuft, können Sie das LangWatch-Anwendungs-Repository herunterladen:

git clone https://github.com/langwatch/langwatchDie Anwendung enthält eine Beispielkonfigurationsdatei mit Umgebungsvariablen. Kopieren Sie diese Datei, damit das Image-Build-Dienstprogramm sie verarbeiten kann:

cp langwatch/.env.example langwatch/.envJetzt sind Sie bereit für den ersten Start:

sudo docker compose up --buildDas System wird einen Moment brauchen, um alle notwendigen Containerschichten für LangWatch herunterzuladen. Sobald dies abgeschlossen ist, wird eine Konsolenmeldung angezeigt, die besagt, dass die Anwendung unter folgender Adresse verfügbar ist:

http://[LeaderGPU_IP_address]:3000

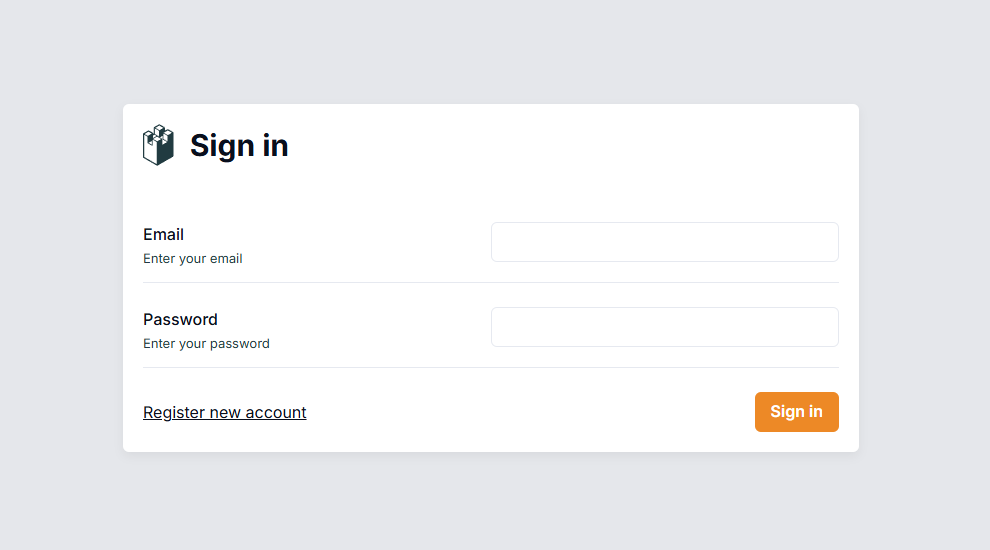

Navigieren Sie zu dieser Seite in Ihrem Browser, wo Sie aufgefordert werden, ein Benutzerkonto zu erstellen:

Im Gegensatz zu Langflow ist bei diesem System die Authentifizierung standardmäßig aktiviert. Nachdem Sie sich angemeldet haben, müssen Sie das System so konfigurieren, dass es Daten von Ihrem Langflow-Server sammelt.

Langflow-Integration

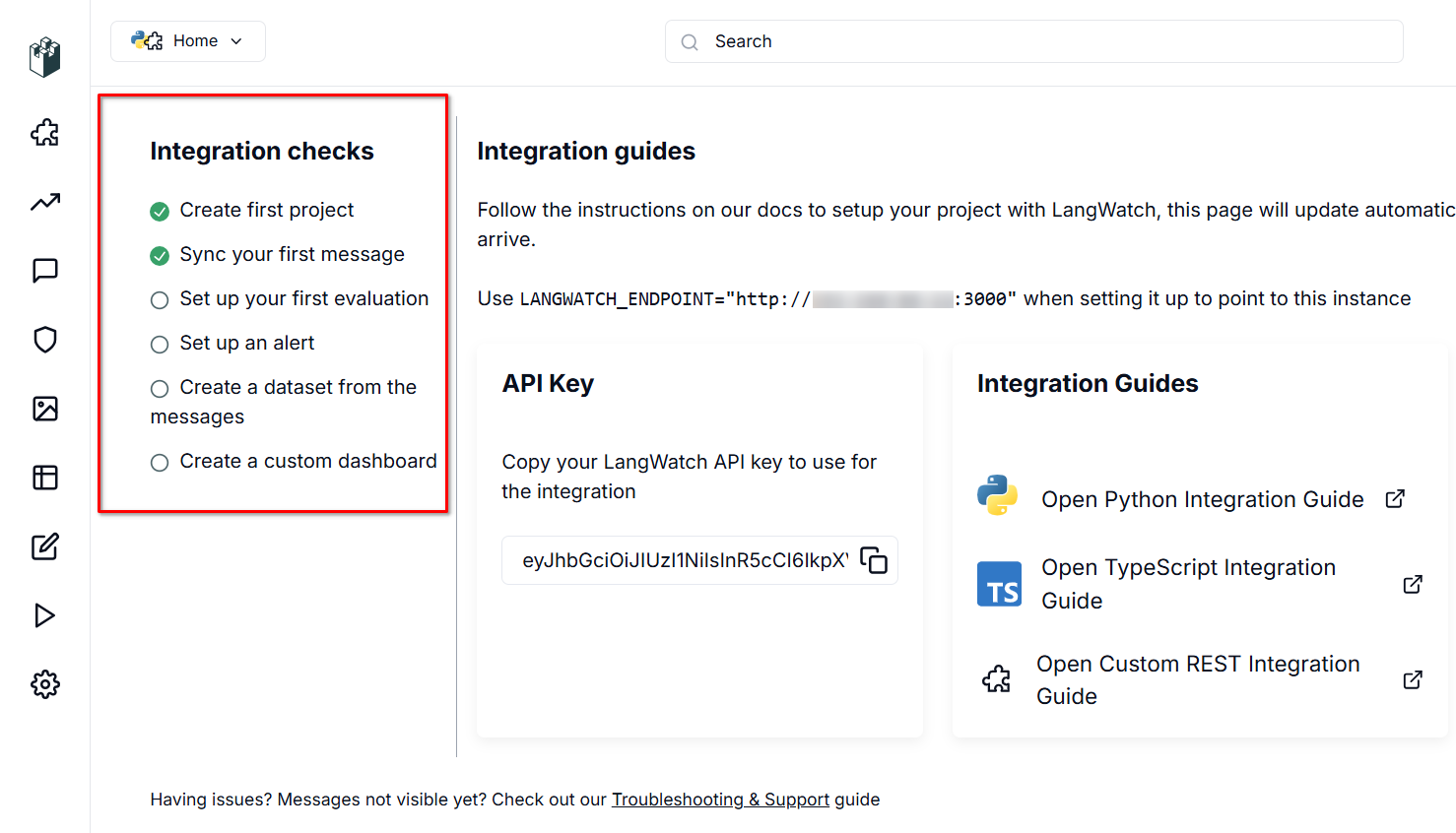

LangWatch benötigt eine Datenquelle, um zu funktionieren. Der Server lauscht auf Port 3000 und verwendet eine RESTful API, die eingehende Daten durch einen automatisch generierten API-Schlüssel authentifiziert.

Um die Datenübertragung zu ermöglichen, müssen Sie zwei Variablen in den Langflow-Konfigurationsdateien setzen: LANGWATCH_ENDPOINT und LANGWATCH_API_KEY. Stellen Sie zunächst eine SSH-Verbindung zu Ihrem Langflow-Server her (der während dieses Vorgangs offline sein sollte).

Wechseln Sie in das Verzeichnis mit der Beispielkonfiguration für Docker:

cd langflow/docker_exampleÖffnen Sie die Konfigurationsdatei zur Bearbeitung:

nano docker-compose.ymlFügen Sie im Abschnitt "Umgebung:" die folgenden Variablen hinzu (ohne Klammern [] oder Anführungszeichen):

- LANGWATCH_API_KEY= [YOUR_API_KEY]

- LANGWATCH_ENDPOINT=http://[IP_ADDRESS]:3000Die YML-Datei erfordert eine bestimmte Formatierung. Befolgen Sie diese beiden wichtigen Regeln:

- Verwenden Sie Leerzeichen (2 oder 4) für die Einrückung, niemals Tabulatoren.

- Behalten Sie die richtige hierarchische Struktur mit konsistenter Einrückung bei.

Speichern Sie die Datei mit Ctrl + O und beenden Sie den Editor mit Ctrl + X. Langflow ist nun startbereit:

sudo docker compose upÜberprüfen Sie nach dem Start, ob alles ordnungsgemäß funktioniert. Erstellen Sie ein neues Projekt oder öffnen Sie ein bestehendes und starten Sie einen Dialog über Playground. Langflow sendet automatisch Daten zur Überwachung an LangWatch, die Sie in der Weboberfläche einsehen können.

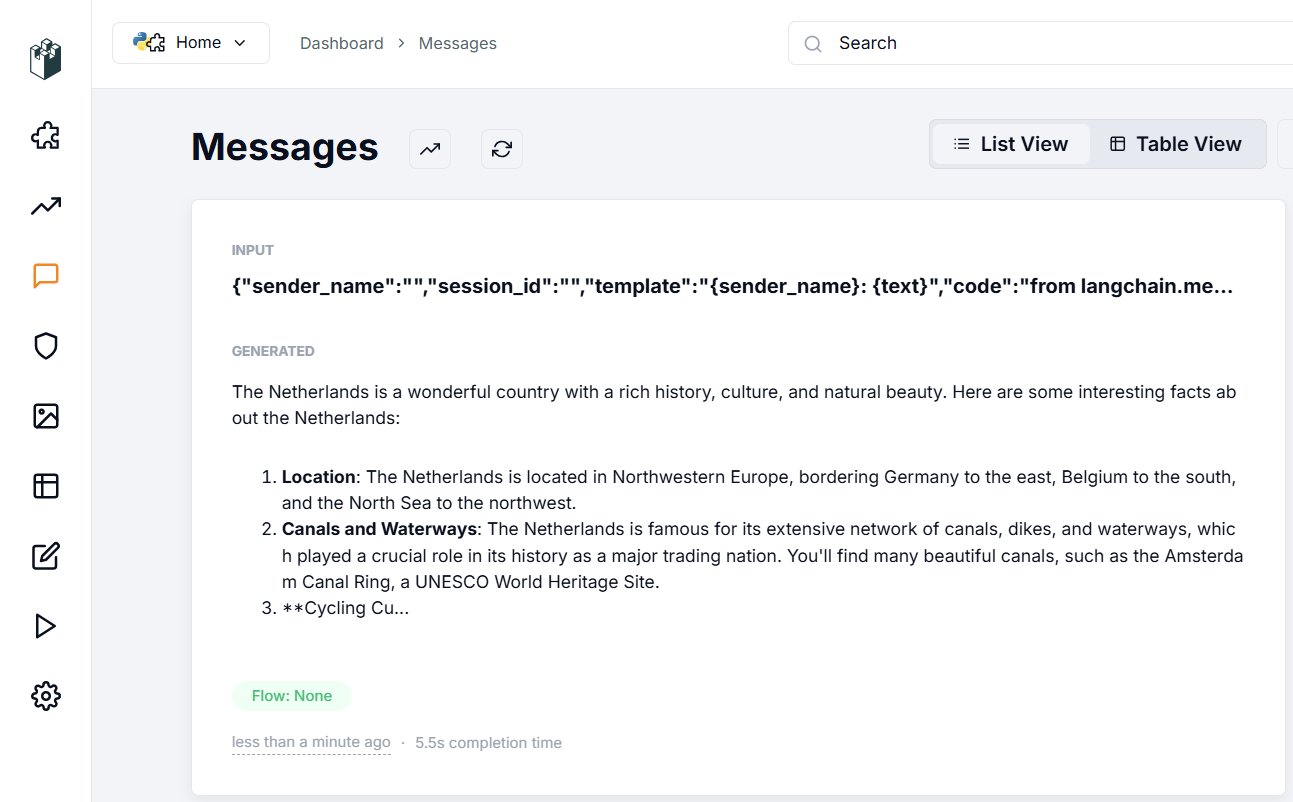

Im Abschnitt zur Überprüfung der Integration erscheint ein Häkchen auf dem Punkt "Sync your first message". Dies zeigt an, dass die Daten aus Langflow erfolgreich in LangWatch fließen und bestätigt, dass Ihre Einrichtung korrekt ist. Schauen wir uns an, was im Abschnitt Messages erscheint:

Der Abschnitt Nachrichten zeigt die in die Anwendung eingegebenen Daten, die für die Antwortgenerierung verwendeten Parameter und die Antwort des neuronalen Netzes selbst an. Sie können die Antwortqualität bewerten und verschiedene Filter verwenden, um die Daten zu sortieren, selbst bei Hunderten oder Tausenden von Nachrichten.

Nach dieser Ersteinrichtung sollten Sie die Funktionen der Anwendung systematisch erkunden. Im Bereich Evaluations können Sie Algorithmen zur Dialogüberprüfung entweder für die Dialogmoderation oder für die Datenerkennung einrichten, z. B. PII Detection. Diese Funktion prüft Eingaben auf sensible Informationen wie Sozialversicherungsnummern oder Telefonnummern.

Die Anwendung bietet sowohl lokale als auch cloudbasierte Optionen über Anbieter wie Azure oder Cloudflare. Um Cloud-Funktionen zu nutzen, benötigen Sie Konten bei diesen Diensten sowie deren Endpunktadressen und API-Schlüssel. Beachten Sie, dass es sich dabei um Drittanbieter handelt, informieren Sie sich also direkt über deren Servicekosten.

Für lokale Optionen bietet die Anwendung ausgefeilte RAG-Funktionen (Retrieval-augmented generation). Sie können die Genauigkeit und Relevanz der von RAG generierten Inhalte messen und die gesammelten Statistiken nutzen, um das RAG-System für genauere Antworten des neuronalen Netzes zu optimieren.

Siehe auch:

Aktualisiert: 04.01.2026

Veröffentlicht: 22.01.2025