Stable Diffusion modelle: Anpassungen und Optionen

Tuning ist eine hervorragende Möglichkeit, jedes Auto oder Gerät zu verbessern. Auch generative neuronale Netze können getunt werden. Heute wollen wir nicht tief in die Struktur von Stable Diffusion eindringen, aber wir wollen bessere Ergebnisse erzielen als ein Standard-Setup.

Dazu gibt es zwei einfache Möglichkeiten: die Installation von benutzerdefinierten Modellen und die Nutzung von Standard-Optimierungsoptionen. In diesem Artikel erfahren wir, wie wir neue Modelle in Stable Diffusion installieren und mit welchen Optionen wir die Hardware effektiver nutzen können.

Wenn Sie lustige Bilder von niedlichen Katzen oder toll aussehendem Essen teilen möchten, posten Sie diese normalerweise auf Instagram. Wenn Sie Anwendungen entwickeln und den Code für alle zugänglich machen wollen, stellen Sie ihn auf GitHub ein. Wenn Sie jedoch ein grafisches KI-Modell trainieren und es mit anderen teilen möchten, sollten Sie sich CivitAI ansehen. Dies ist eine riesige Plattform, um Wissen und Ergebnisse mit Community-Mitgliedern zu teilen.

Bevor Sie mit dem Herunterladen beginnen, müssen Sie das Arbeitsverzeichnis ändern. Alle KI-Modelle in Stable Diffusion befinden sich im Verzeichnis "models": Bevor Sie mit dem Herunterladen beginnen, müssen Sie das Arbeitsverzeichnis ändern. Alle KI-Modelle in Stable Diffusion befinden sich im Verzeichnis "models":

cd stable-diffusion-webui/models/Stable-diffusionPrüfen wir, welche Modelle standardmäßig bereitgestellt werden:

ls -a'Put Stable Diffusion checkpoints here.txt' v1-5-pruned-emaonly.safetensors

Es gibt nur ein Modell mit dem Namen "v1-5-pruned-emaonly" und der Erweiterung "safetensors". Dieses Modell ist ein guter Ausgangspunkt, aber wir haben fünf weitere interessante Modelle. Lassen Sie uns diese herunterladen und mit dem Standardmodell vergleichen.

Stabile Diffusionsaufforderungen

Um den Unterschied zwischen den Modellen visuell zu verdeutlichen, haben wir uns einfache Aufforderungen ausgedacht:

princess, magic, fairy tales, portrait, 85mm, colorful

Bei vielen Modellen kann die genaue Darstellung von Geometrie und Gesichtszügen eine große Herausforderung darstellen. Fügen Sie daher negative Eingabeaufforderungen hinzu, um sicherzustellen, dass Bilder ohne diese Merkmale erzeugt werden:

poorly rendered face, poorly drawn face, poor facial details, poorly drawn hands, poorly rendered hands, low resolution, bad composition, mutated body parts, blurry image, disfigured, oversaturated, bad anatomy, deformed body features

Stellen Sie den maximalen Wert der Abtastschritte (150) ein, um mehr Details im Ergebnis zu erhalten.

Standardmodell

Das Standardmodell ist für solche Aufgaben gut geeignet. Allerdings sind einige Details nicht ganz genau. Zum Beispiel gibt es ein Problem mit den Augen: Sie sind eindeutig unproportional:

Wenn man sich das Diadem ansieht, ist es ebenfalls schief und asymmetrisch. Der Rest der Details ist gut ausgeführt und entspricht den Vorgaben. Der Hintergrund ist unscharf, weil wir die Vorgabe "85mm" eingestellt haben. Dies ist eine in der professionellen Fotografie sehr häufig verwendete Brennweite für Porträts.

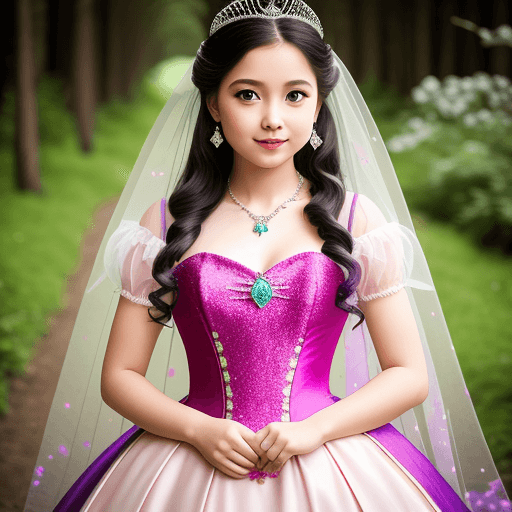

Realistische Vision

Dieses Modell ist hervorragend für Porträts geeignet. Das Bild sieht aus, als wäre es mit einem Qualitätsobjektiv mit der angegebenen Brennweite aufgenommen worden. Die Proportionen von Gesicht und Körper sind genau, das Kleid sitzt perfekt und das Diadem auf dem Kopf sieht ästhetisch ansprechend aus:

Übrigens empfiehlt der Autor, die folgende Vorlage für negative Prompts zu verwenden:

deformed iris, deformed pupils, semi-realistic, cgi, 3d, render, sketch, cartoon, drawing, anime:1.4), text, close up, cropped, out of frame, worst quality, low quality, jpeg artifacts, ugly, duplicate, morbid, mutilated, extra fingers, mutated hands, poorly drawn hands, poorly drawn face, mutation, deformed, blurry, dehydrated, bad anatomy, bad proportions, extra limbs, cloned face, disfigured, gross proportions, malformed limbs, missing arms, missing legs, extra arms, extra legs, fused fingers, too many fingers, long neck

Aber auch mit unseren recht einfachen Aufforderungen ist das Ergebnis hervorragend.

Laden Sie die Vorlage hier herunter: Realistische VisionBewusst

Ein weiteres erstaunliches Modell für solche Zwecke. Die Details sind auch hier gut ausgearbeitet, aber seien Sie vorsichtig und überwachen Sie die Anzahl der Finger. Dies ist ein sehr häufiges Problem bei neuronalen Netzen: Sie können oft zusätzliche Finger oder sogar ganze Gliedmaßen zeichnen.

Das Erstellen visueller Linien ist eine der beliebtesten Filmtechniken. So hat sich dieses Modell auch dafür entschieden, eine Person vor dem Hintergrund eines Waldweges zu zeichnen.

Laden Sie das Modell hier herunter: Bewusst

OpenJourney

Unter den generativen neuronalen Netzen hat Midjourney (MJ) besondere Aufmerksamkeit erhalten. MJ war ein Pionier auf diesem Gebiet und wird oft als Beispiel für andere herangezogen. Die Bilder, die es erzeugt, haben einen einzigartigen Stil. OpenJourney ist vom MJ-Stil inspiriert und ist eine entsprechend abgestimmte Stable Diffusion.

Es werden Bilder erzeugt, die wie ein Cartoon aussehen. Sie sind lebendig und hell. Um bessere Ergebnisse zu erzielen, fügen Sie die Stil-Eingabeaufforderung mdjrny-v4 hinzu.

Laden Sie das Modell hier herunter: OpenJourney

Alles

Dieses Modell erzeugt Bilder, die denen eines professionellen Manga-Künstlers (einer Person, die Comics zeichnet) ähneln. Wir haben also eine Prinzessin im Anime-Stil.

Dieses Modell wird auf Bilder mit einer Auflösung von 768x768 trainiert. Sie können diese Auflösung einstellen, um bessere Ergebnisse als die Standardauflösung 512x512 zu erzielen.

Laden Sie das Modell hier herunter: Irgendetwas

Unternehmen Memphis

Dieser Bildstil erlangte in den frühen 2020er Jahren große Popularität und wurde in verschiedenen High-Tech-Unternehmen als Unternehmensstil verwendet. Trotz der Kritik ist er häufig in Präsentationen und Websites zu finden.

Die Prinzessin erwies sich als minimalistisch, aber recht hübsch. Besonders amüsant waren die Details, die das Modell auf dem Hintergrund platzierte.

Laden Sie das Modell hier herunter: Unternehmen Memphis

Stabile Diffusionsoptionen

Stabile Diffusion verbraucht viele Ressourcen, so dass viele Optionen für sie entwickelt worden sind. Die beliebteste von ihnen ist --xformers. Diese Option ermöglicht zwei Optimierungsmechanismen. Der erste reduziert den Speicherverbrauch und der zweite dient zur Erhöhung der Geschwindigkeit.

Wenn Sie versuchen, --xformers ohne zusätzliche Schritte hinzuzufügen, erhalten Sie eine Fehlermeldung, die besagt, dass die Pakete(torch und torchvision) für unterschiedliche Versionen von CUDA® kompiliert wurden. Um dies zu beheben, müssen wir die virtuelle Python-Umgebung (venv) aufrufen, die für Stable Diffusion verwendet wird. Danach installieren Sie die Pakete für die gewünschte CUDA-Version (v1.18).

Zunächst müssen wir den apt-Paket-Cache aktualisieren und den Paketinstaller für Python (pip) installieren. Der nächste Schritt besteht darin, Python venv mit dem Skript activate zu aktivieren:

source stable-diffusion-webui/venv/bin/activateDanach ändert sich die Eingabeaufforderung zu (venv) username@hostname:~$. Installieren wir nun die Pakete torch und torchvision mit CUDA® 11.8:

pip install torch==2.0.0+cu118 torchvision==0.15.1+cu118 --index-url https://download.pytorch.org/whl/cu118Dieser Vorgang kann einige Minuten dauern, da die Pakete recht groß sind. Sie werden gerade genug Zeit haben, um sich einen Kaffee einzuschenken. Schließlich können Sie die virtuelle Umgebung deaktivieren und Stable Diffusion mit der Option --xformers starten (ersetzen Sie [user] und [password] durch Ihre eigenen Werte):

deactivate./webui --xformers --listen --gradio-auth [user]:[password]Die schnellere Alternative zu --xformers ist --opt-sdp-no-mem-attention. Sie verbraucht mehr Speicher, arbeitet aber etwas schneller. Sie können diese Option ohne zusätzliche Schritte verwenden.

Schlussfolgerung

Heute haben wir die Möglichkeiten von Stable Diffusion in Kombination mit anderen Modellen und Optimierungsoptionen untersucht. Denken Sie daran, dass Sie durch Erhöhen oder Verringern der Anzahl der Abtastschritte den Detailgrad des endgültigen Bildes anpassen können.

Natürlich ist dies nur ein kleiner Teil dessen, was Sie mit einem solchen generativen neuronalen Netz tun können. Bestellen Sie also gleich einen GPU-Server und fangen Sie an zu experimentieren. Viele weitere Entdeckungen und Möglichkeiten warten auf Sie. Schnelle und leistungsstarke Grafikkarten werden Ihnen helfen, Zeit zu sparen und tolle Bilder zu erzeugen.

Siehe auch:

Aktualisiert: 04.01.2026

Veröffentlicht: 25.11.2024